1、

可以过滤词汇表中特定的字符串和单词,完成大写转小写的功能。

2、

根据空格和符号完成分词,还可以完成对数字、字母、E-mail地址、IP地址和汉字的分析处理,还可以支持过滤词汇来代替可以过滤的过滤功能实现。

3、

对西方字符进行基本词法分析的分词器。在处理词汇单元时,使用非字母字符作为切分符号。分词器不能过滤单词,但可以分析和分割单词。输出词法单元完成小写字符转换AvePreview(图片浏览器),去除标点符号等分隔符。

在全文检索系统的开发中,通常用于支持西方符号的处理,但不支持中文。由于没有完成词过滤功能,所以不需要词库过滤支持。分词策略简单,使用非英文字符作为分隔符,不需要分词词典的支持。

4、

使用空格作为分隔符的分词标记器。处理词汇单元时,使用空格字符作为分隔符。分词器不执行词法过滤或小写字符转换。

其实它可以用来支持特定环境下西方符号的处理。由于没有完成词过滤和小写字符转换功能PS国外花纹笔刷下载,所以不需要过滤词库支持。词法切分策略只使用非英文字符作为分隔符关键词分词器绿色版,不需要分词词库支持。

5、

将整个输入视为单个词汇单元,以便于对特定类型的文本进行索引和检索。使用关键字分词器为邮政编码和地址等文本信息创建索引项非常方便。

6、

内部调用分词器对中文单词进行分词关键词分词器绿色版,通过完成过滤功能,可以实现中文的多分词分词和停用词过滤。在 .0 版中已弃用。

7、

处理中文的功能与分析仪基本相同台历模板王免费版,分为单双字节汉字。在 .0 版中已弃用。

8、 每个

per 主要用于不同的 的不同场合。例如,对于文件名,你需要使用它,对于文件内容,你只能使用它。分类器可以通过 ( ) 添加。

9、

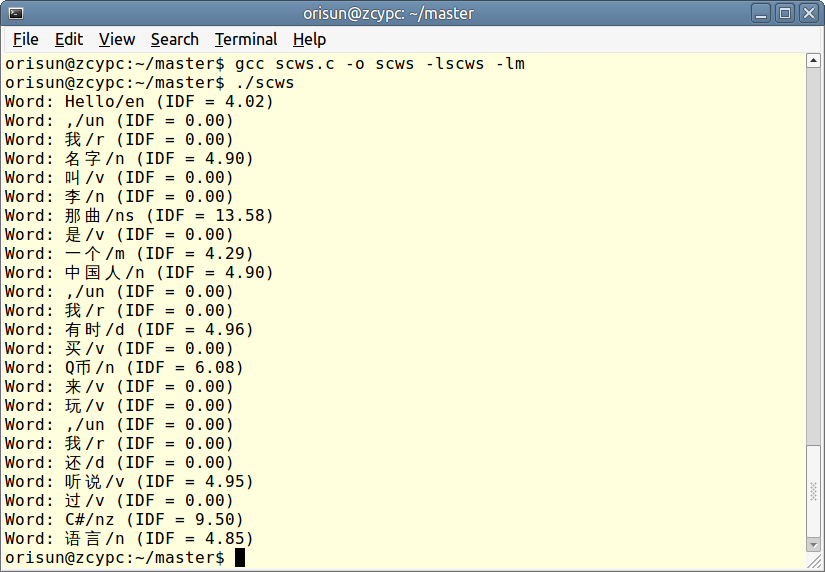

实现了基于字典的正反向全切分和正反向最大匹配分割两种方法。是第三方实现的分词器,继承自的类,处理成中文文本。

10、JE-

JE-Yes 中文分词组件,需要下载。

11、

中文分词系统是在中科院张华平、刘群开发的基础上完成的一个java开源分词项目,简化了原有分词程序的复杂性,旨在提供一个比较好的中文分词爱好者。学习机会。

12、 --

-- 智能词典的智能中文分词模块。该算法基于隐马尔可夫模型(Model,HMM)。它是对中科院计算所中文分词程序(基于Java)的重新实现。可以直接搜索引擎提供简体中文分词支持。

13、

中文分词效率高且可扩展。引入隐喻,完全面向对象的设计,先进的概念。它的效率比较高,在PIII 1G内存的个人电脑上,1秒就能准确切分100万个汉字。文章基于无限数量的词典文件进行有效分割,实现词汇的分类和定义。能够合理地解析未知词汇。

14、

使用 Chih-Hao Tsai 的 MMSeg 算法 ( ) 实现的中文分词器,并实现了 's 和 solr's 以方便在和 Solr 中使用。 MMSeg 算法有两种分词方法:并且,都基于前向最大匹配。添加了四个规则来过度思考。官方表示:单词正确识别率达到98.41%。两种分词算法都实现了。

发表评论